Como muchos ya sabréis la optimización técnica es el segundo gran pilar del SEO, junto al marketing de contenidos. Es un área fundamental del desarrollo web.

Sobre el marketing de contenidos ya encontraremos alguna excusa para tratarlo. En cuanto al posicionamiento orgánico sigue leyendo si quieres ver brevemente una serie de técnicas y cómo validarlas con las herramientas para webmasters de Google.

Rastreo del sitio

Los buscadores utilizan robots automatizados conocidos como "arañas" para buscar y rastrear contenidos en la web.

La araña de Google (Googlebot) encuentra las URLs siguiendo los enlaces y leyendo los sitemaps facilitados por nosotros, los webmasters. Interpreta el contenido y añade las páginas al índice de Google. Si la araña de Google no puede rastrear nuestro sitio de manera eficiente, la búsqueda orgánica no va a funcionar bien. Por lo tanto el primer objetivo al que nos enfrentaremos es maximizar la eficiencia de las visitas de la araña de Google.

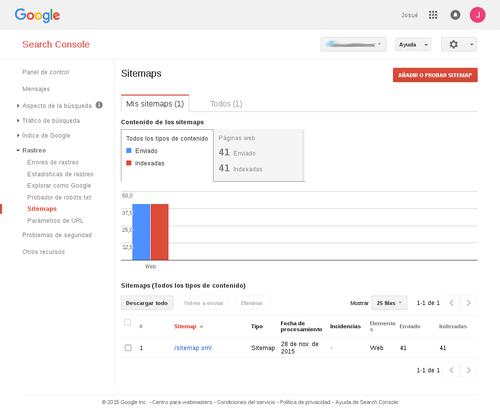

Estructura y sitemaps. Es importante que la información de nuestro sitio web esté accesible en 3 clicks como máximo mediante una estructura de navegación sencilla. Además debemos hacer la información accesible a través de URL limpias. La estructura y contenidos de un sitio se pueden enviar a los navegadores mediante Sitemaps, en el caso del Search Console de Google en la opción Rastreo > Sitemaps.

Velocidad de carga y soporte de dispositivos móviles. Cuando hayamos conseguido que la información sea fácilmente accesible para el usuario y para los robots, hay que hacer que la carga de las páginas sea lo más rápida posible.

En los últimos cambios incorporados por Google, se tiene en cuenta usabilidad del sitio web en el algoritmo de valoración, siendo la velocidad de carga y el diseño web adaptativo (responsive) dos factores fundamentales. No puede faltaros el addon de firefox "Firebug" para medir la velocidad de carga de cada petición o las herramientas de desarrollador de Chrome para saber qué recursos se pueden optimizar. La herramienta PageSpeed Insigths de Google sugiere medidas para mejorar los tiempos de carga. Hay muchas, pero algunas de las técnicas básicas de optimización de la velocidad serían el cacheado de páginas, la compresión de archivos css y js, y usar el menor número de peticiones HTTP en la carga de la página.

Eficiencia del rastreo e indexado

Una vez que nos hemos asegurado de tener un contenido estructurado y fácilmente accesible a los robots, hay que evaluar cómo estos interpretan e indexan ese contenido. Uno de los principios clave del diseño orientado al posicionamiento es el "contenido duplicado" o "ligero". Esto se refiere a URL's que devuelven un código 200 HTTP, indicando que el recurso existe y esta disponible a través de otras URL's (duplicado) o que no tienen valor para los usuarios (thin/ligero).

El algoritmo de Google penaliza los sitios con altos grados de contenido duplicado. Por lo tanto es importante el consolidar cualquier contenido duplicado, ligero o heredado.

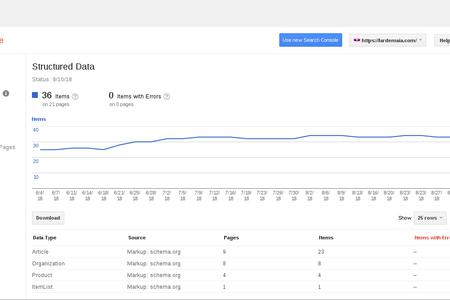

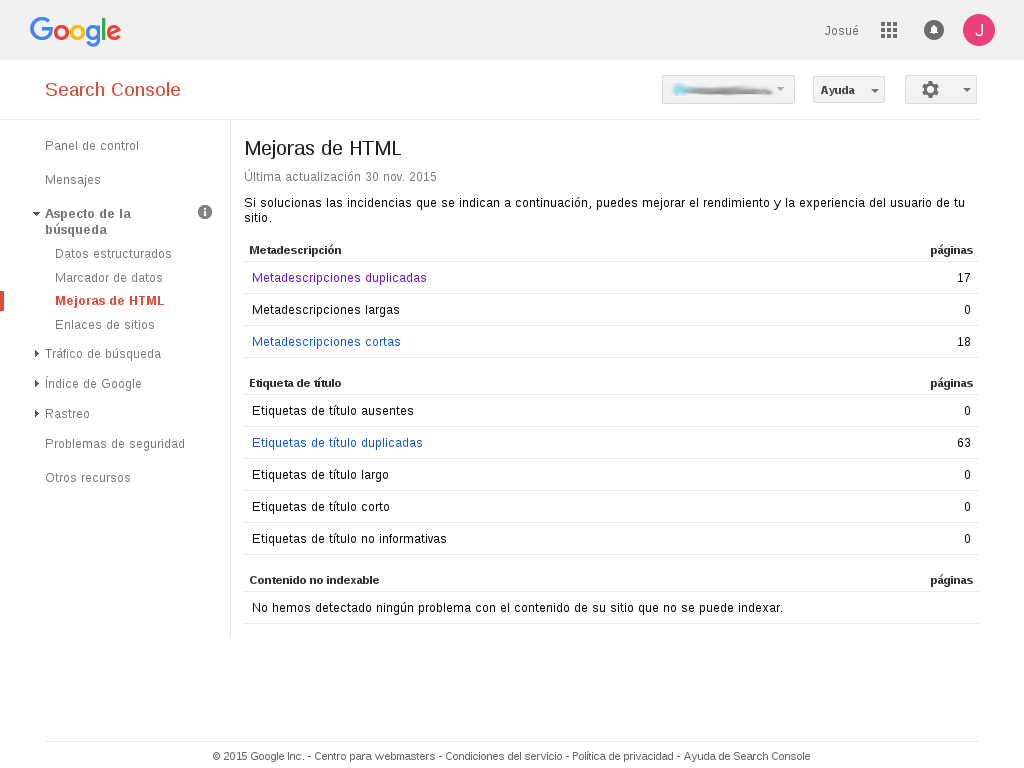

Diagnóstico. Una forma cómoda y completa de detectar contenidos duplicados es acudir a las herramientas para webmasters de Google. Si vamos a Aspecto de la búsqueda > Mejoras de HTML podemos revisar qué contenidos tienen idéntica etiqueta <title> o idéntico meta description lo que ayuda a detectar problemas de contenido duplicado o etiquetado de manera deficiente.

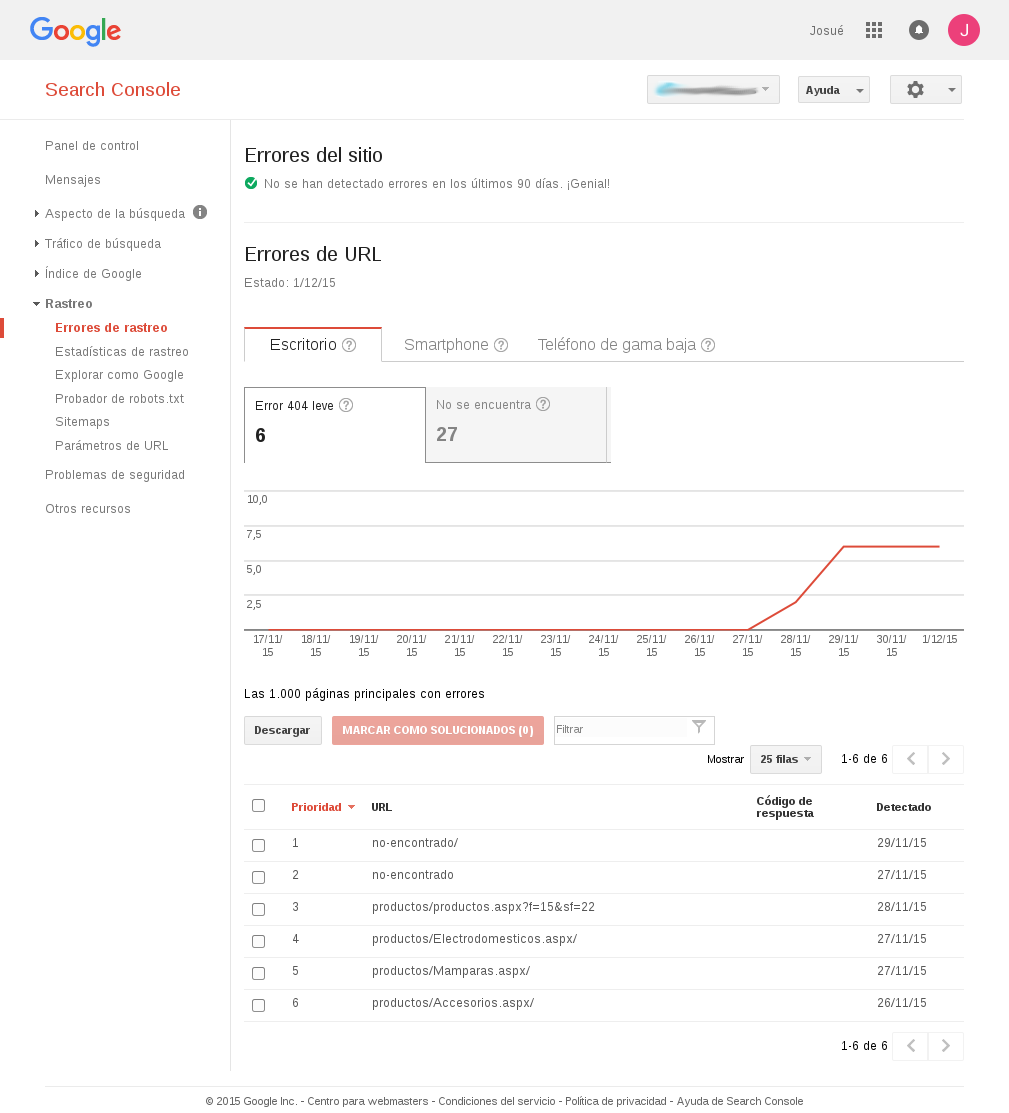

En Rastreo > Errores de rastreo podemos detectar errores 404. Estas son instancias donde una página que no existe devuelve un código 404 correcto. Desde la perspectiva de un robot, el contenido de la página no está relacionado a la respuesta HTTP del servidor. A los usuarios se les muestra un mensaje de página no encontrada, pero sin la adecuada gestión desde el servidor web, para el robot el mensaje es que la página existe y debe indexarla.

Finalmente en Rastreo > Sitemaps, el testar los sitemaps nos da información sobre cómo Google interpreta la estructura del sitio. Hay que prestar atención al ratio de URL's indexadas frente a las URL's enviadas, una diferencia grande puede ser indicativo de que tenemos un problema de contenido duplicado o ligero.

Redirecciones de URL. En los casos donde el contenido duplicado o heredado tiene una nueva URL clara, la práctica más habitual es una redirección en el servidor. Hay que asegurarse de hacer redirecciones permanentes (301 HTTP).

Gracias por vuestra atención.